Speichertypen

RAID und BBU

RAID Controller mit BBU und ohne BBU gilt nur für HDD hier geht es zu den RAID Controller mit BBU und ohne BBU gilt nur für SSD die BBU schreibt die Daten zurück vom Speicher auf die Festplatte, die Batterie muss alle 4 Jahre getauscht werden, bedingt durch die Alterung 5-8 Jahre können erreicht werden, aber wer fährt seinen Tank schon bis zum Ende leer, ein wenig Reserve macht immer Sinn.Write Back und Write Through, beim Write Back schickt der Controller einen Bestätigungsbefehl an OS zum Schreiben der Daten vom OS zu den Festplatten, in der Zwischenzeit werden die Daten so lange im Cache gehalten, bis die Daten vom Controller auf die Festplatten geschrieben wurden. Schreibleistung wird gesteigert.Ist keine Batterie (BBU) vorhanden, sind die Daten weg! Also mit BBU Einschalten und ohne BBU Ausschalten. Bei der Write-Through-Strategie sendet einen Bestätigungsbefehl erst dann an das Betriebssystem, wenn die Daten sicher auf die Festplatte geschrieben wurden, das kostet Zeit, das Verfahren Übertragungs- beziehungsweise System-Performance, da die Informationen ohne Zwischenpufferung direkt, ohne Rücksicht auf aktuelle Systemressourcen, auf die Festplatte geschrieben werden, die Schreibleistung mit aktiviertem Write-Through-Cache unterscheidet sich kaum von der Performance eines Controllers ohne Cache-Unterstützung. Read Ahead und adaptive Read Ahead. Bei der Read Ahead Strategie fordert der RAID-Controller neben den tatsächlichen Daten auf der Festplatte auch die Daten, die daneben liegen, an. Diese „vorweggenommenen“ Daten werden in den Cache zwischengespeichert. Werden beim nächsten Request diese Daten verlangt, kann der Controller diese direkt aus dem Puffer lesen und an das Betriebssystem weiterleiten. Ein Zugriff auf die Festplatte ist dann nicht mehr erforderlich. Das spart Zeit und erhöht die Performance bei Datenanforderungen. Besonders bei zusammenhängenden Datenstrukturen, die sequenziell gelesen werden können, wie Video-Streams oder Audio-Files, kann dieses Verfahren seine besondere Stärke ausspielen. Auch die Defragmentierung einer Festplatte wirkt sich positiv auf die Performance des Storage-Systems aus, wenn die Read-Ahead-Funktion des Cache-RAID-Controllers aktiviert ist.Die Adaptive-Read-Ahead-Option beinhaltet eine „intelligente“ Read-Ahead-Strategie. Diese aktiviert Read-Ahead-Lesezugriffe erst dann, wenn zwei aufeinander folgende Read-Anweisungen Daten aus zwei hintereinander liegenden Sektoren der Festplatte auslesen. Erhält der RAID-Controller Daten aus zufälligen Sektoren der Festplatte, schaltet er in den No-Read-Ahead-Modus um. Der Controller wertet aber weiter alle Leseanweisungen aus, ob sie aus zwei hintereinander liegenden Sektoren kommen. Ist dies der Fall, kann er sofort wieder Read-Ahead-Zugriffe einleiten.Im No-Read-Ahead-Modus liest der Storage-Controller nicht „vorausschauend“ die Daten ein. Das heißt, es wird nur jeweils ein Sektor eingelesen, auch wenn der folgende Nachbarsektor die nächsten Lesedaten enthält. Welche Read-Strategie die bessere ist, hängt letztlich von der Anwendung ab und von deren Datenstruktur auf der Festplatte.Cache I/O und Direct I/O der Cache und Direct-I/O-Strategie bezieht sich jeweils auf ein logisches Laufwerk des RAID-Controllers. Weiterhin haben die beiden Cache-Optionen keine Auswirkungen auf die Read-Ahead-Einstellungen des RAID-Systems.Die Cache I/O-Einstellung der Cache-Policy spezifiziert, dass alle Lesezugriffe vom RAID-Controller zwischengespeichert werden. Das bedeutet, dass das Betriebssystem die Daten nicht direkt von der Festplatte erhält, sondern vom Cache des Controllers.Dagegen erfolgen die Lesezugriffe im Direct-I/O-Modus nicht ausschließlich aus dem Cache-Speicher des Controllers. So werden während einer Leseanweisung die Daten simultan zum Controller-Cache und zum Betriebssystem übertragen. Falls ein nachfolgender Leseauftrag – ein sogenannter Subsequent-Read – Daten aus dem gleichen Datenblock benötigt, können diese aus dem Controller-Cache direkt angefordert werden. RAID Controller mit BBU und ohne BBU gilt nur für SSD Cache Schutz Mega RAID Controller bieten einen integrierten Cache zur Beschleunigung von Schreibzugriffen. Damit der Inhalt des Caches im Falle eines Stromausfalles erhalten bleibt, kann dieser mit LSI Cache Vault oder einer Batterie Backup Unit geschützt werden. Weitergehende Informationen zu den Cache Einstellungen zeigt der Artikel Cache, Einstellungen von RAID Controllern und Festplatten. Cache Vault beim Cache Schutz mittels Cache Vault kommt kein Akku zum Einsatz. Stattdessen liefert ein Kondensator im Falle eines Stromausfalles kurzzeitig genügend Energie, um den Inhalt des flüchtigen Caches in einen nichtflüchtigen Flash Speicher zu schreiben. Der Inhalt des Caches bleibt damit im Flash Speicher erhalten, egal, wie lange der Stromausfall dauert. Außerdem ist diese Lösung wartungsfrei, da keine Akkus vorhanden sind, die in regelmäßigen Abständen erneuert werden müssten. Batterie Backup Unit Beim Cache Schutz mittels Batterie Backup Unit (BBU) hält ein Akku den Inhalt des Caches. Abhängig von der Kapazität des Akkus und des aktuellen Ladestandes kann der Inhalt des Caches bis zu 72 Stunden erhalten werden. Dauert der Stromausfall länger, geht der Inhalt des Caches verloren. Intel Solid-State Drives in Server Storage Applications (www.intel.com) Intel SSD DC S3500 Series Workload Characterization in RAID Configurations (www.intel.com)

Pro und Contra

Speichern muss jeder, nur auf welchem Medium? HDD Harddisk Drive, SSD Solid State Drive oder NVMe Abkürzung von nonvolatile Memory.

Die Auswahl ist groß, die Technik schon alt und neuste Innovationen sind mit Helium gefüllte Festplatten, um Wärmeentwicklung entgegenzuwirken 👍

Was machen gute rotierende Festplatten aus?

HDD Harddisk Drive

Die Datentransfers sind abhängig von Umdrehungen pro Minute, U/min und ihrem Cache. Der sogenannte Zwischenspeicher, das fängt bei der Gold-Serie von Westen digital Festplatten bei 256 MB an und ab dem 14-TB-Modell mit 512 MB für anspruchsvolle Speicherumgebungen, mit Speicherkapazitäten zwischen 1 TB und 18 TB Modellreihen.

Bis 2,5 Mio. Stunden MTBF, Vibrationsschutz und niedrigem Energiebedarf dank HelioSeal™-Technologie [ab 12-TB-Version]. WD Gold SATA HDDs der Enterprise-Klasse sind speziell für Speichersysteme und Rechenzentren von Unternehmen entwickelt und bieten die herausragende Performance.

Also der ideale Einsatz für eine zuverlässige Datensicherung.

PMR, SMR, CMR

PMR, also Perpendicular Magnetic Recording, ist eine Methode, bei der horizontal und senkrecht auf Platter magnetisiert wird. PMR ist der Nachfolger von Longitudinal Magnetic Recording (LMR) und erreicht eine dreifach höhere Datendichte als der Vorgänger LMR – der Lese-/Schreibkopf wurde dafür optimiert und die senkrechte Positionierung trägt hier ebenfalls einen Teil dazu bei. Dieses Verfahren ist entwickelt worden, um bei den gängigen 3,5-Zoll-Festplatten mehr als 750 GB bereitstellen zu können. Mit PMR ist es möglich, dass auf der Festplatte direkt auf den finalen Speicherplatz der Daten geschrieben wird, ohne dass die Daten erst noch einmal auf der Festplatte umgeschrieben werden müssen.

SMR

SMR, das Single Magnetic Recording, schreibt Daten überlappend, denn es basiert auf dem Konzept, dass der Schreibkopf größer und weniger filigran ist als der Lesekopf. Deshalb schreibt der Schreibkopf sehr nah an der vorherigen Bahn, sodass diese aber noch lesbar bleibt. Überschrieben werden aber die Daten der folgenden Bahn, was bedeutet, dass eventuell die nächste Bahn nach einem erfolgreichen Rekordding-Vorgang auch erneut geschrieben werden muss. Läuft es nicht optimal, dann muss sich dieses „Neu-Schreiben“ immer weiter fortsetzen. Dadurch verlangsamt sich der Schreibe Vorgang unter Umständen drastisch. Der Vorteil dieser Technologie ist jedoch, dass die Speicherdichte im Vergleich zum PMR erhöht wird.

SMR Festplatten verfügen in den äußeren Spuren auch über einen On-Disk-Cache, zusätzlich zum Standard Controller-Cache. Hier kommt die PMR-Technologie zum Einsatz. Nach der Aufzeichnung werden die Daten so bald wie möglich vom Controller in den SMR-Bereich übertragen. Dieser Vorgang ist zum einen letztlich platzsparender, zeigt aber auch den großen Unterschied zur CMR-Technologie auf: Wenn der schnellere On-Disk-Cache gefüllt ist, bevor der Controller die Daten in den SMR-Bereich übertragen kann, dann muss der Cache erst geleert, genauer gesagt neu geschrieben werden, bevor wieder neue Daten gespeichert werden können. Deshalb kann es bei großen Dateien vorkommen, dass nach einer bestimmten Datenmenge die Übertragungsrate einbricht, weil der Cache voll ist und erst wieder freigeräumt werden muss.

Einsatzbereich der WD Blue

SMR Festplatte idealer Einsatz als File Archiv, einmal beschrieben und primär zum Speichern für Filme, Fotos, ISO Image, Software und als Ablage geeignet.

Benutze dies in meinem vServer als erweiterten Datenträger, das OS auf einer SSD (50 GB) und dann folgt schon die erste HDD (2 TB).

Auch im Einsatz, die WD RED 1 TB 2,5 Zoll (6,35 cm) 16 MB Cache 7200 U/min sind bei mir im Server als RAID 10 mit 8 HDD konfiguriert. Die schaffen rund ihre 350/700 MByte pro Sekunde, ein Teil davon hängt auch vom RAID Controller ab, mit seinen 4 GB RAM macht es als Zwischenpuffer viel aus.

Meine im Einsatz befindliche Hardware:

HDD Baujahr August 2015

Der andere Server ist mit WD Black WD 1 TB JPLX 32 MB Cache 7200 U/min auch mit 8 HDD im RAID 10, da laufen die 600/900 MByte/s konstant durch.

Der Cache im RAID Controller ist auch für die kontinuierliche Befüllung der Festplatten zuständig, drum merke, um so mehr GB der Controller hat, umso besser.

Baujahr Juli 2018 und läuft bis jetzt ohne einen Ausfall, bei 8 HDD im RAID 10 komme ich auf knappe 3,7 TB.

15.01.2023 Festplatten laufen immer noch ohne Ausfall.

WD10SPSX

Die neuen kleinen Black jetzt mit noch mehr Cache, 64 MB sind schon

eine ganze, Menge. Hier sei auch erwähnt das Baracuda 5 TB HDD im

Angebot hat es sind allerdings SMR die mit 128 MB doppelt so viel Cache

haben allerdings nur mit 5400 U/min drehen statt wie bei Western Digital

mit 7200 U/min. Baracuda 2,5“ mit 5 TB 128 MB Cache 5400U/min und 15 mm

Bauhöhe Seagate hat die Speicherkapazität bei Festplatten im

2,5-Zoll-Format auf 5 TByte in einem 2,5-Zoll-Gehäuse angehoben,

allerdings passt das mit 15 mm Höhe nicht mehr in schlanke Notebooks.

Idealerweise

aber in das Synology Disk Station DS-411 Slim mit 4 × 5 TB bei 20 TB

Brutto hast du dann eine lange Sicherung Historie. Geringen

Stromverbrauch, diese würde ich auch nicht als RAID 10 konfigurieren, es

empfiehlt sich ein RAID 0, da es sich hier nur um das 2te

Sicherheitsbackup geht, also die Kopie der Kopie

SSD Solid Drive State

Standard SSD in Notebooks und Arbeitsplatzrechner nicht mehr zu verzichten, die Zeitersparnis beim Booten und Aufrufen von Programmen ist enorm.

NVMe

im Server Einsatz, wenn viele User auf Daten zugreifen oder Datenbanken schnell reagieren müssen, ist die NVMe die richtige Wahl.

Randnotiz: Backupserver sollte allerdings immer getrennt vom produktiven Server liegen, am besten noch in einem separaten VLAN.

Wer dieses noch steigern möchte, kann NVMe Festplatten für die vServer einsetzen und das Sicherungskopie wiederum auf günstigere HDD speichern.

TRIM

TRIM testen und einschalten.

Die Unterstützung des ATA-Kommandos TRIM ist für die Nutzung einer SSD essenziell, da ohne TRIM-Unterstützung die Performance des Flash-Speichers mit der Zeit erheblich abnimmt.

Die physikalischen Eigenschaften von Flash-Zellen, lässt sich nur dann ohne Wartezyklen beschreiben, wenn die entsprechenden Zellen leer sind. Da das Betriebssystem Dateien jedoch nur aus dem Inhaltsverzeichnis des Dateisystems löscht und der Controller der SSD von diesem Löschvorgang nichts mitbekommt, muss dieser beim erneuten Zugriff auf die Zelle diese erst löschen, bevor er sie beschreiben kann.

Mit dem TRIM-Feature teilt das Betriebssystem dem SSD-Controller mit, welche Daten nicht mehr benötigt werden, sodass dieser in Ruhephasen die nicht benötigten Zellen löschen kann, um sie später ohne Performanceverlust wieder beschreiben zu können. Tools wie Samsung Magician und Crystal DiskInfo zeigen an, ob das TRIM-Feature aktiv ist.

Im Normalfall unterstützen Windows10 und auch Linux das TRIM-Kommando mit modernen SSDs. Eine Ausnahme bildet macOS, das TRIM standardmäßig nur unterstützt, wenn SSDs von Apple genutzt werden. Wer einen älteren Mac mit einer SSD eines anderen Herstellers aufrüsten will, sollte daher nach der Inbetriebnahme im Terminal folgendes Kommando absetzen: sudo trimforce enable.

In den Systeminformationen wird unter SATA/SATA Express der TRIM-Status für die installierten Speichermedien angezeigt.

Der Standardtreiber von Microsoft arbeitet mit den NVMe-basierten SSDs von Samsung nicht optimal zusammen. Dadurch sinkt die Leistung der SSDs bei bestimmten Schreiboperationen erheblich. Der Grund für die niedrige Performance beim zufälligen Beschreiben von Flashzellen liegt laut Samsung daran, dass der Microsoft-Treiber den Cache der SSD nicht nutzt. Stattdessen werden Daten über den FUA-Befehl (Force Unit Access) direkt in die Flashzellen geschrieben.

Der Samsung-Treiber behebt dieses Problem. Für die Datensicherheit nutzt der Treiber das in NTFS integrierte Flush-Kommando. Dadurch ist gewährleistet, dass bei einem plötzlichen Stromausfall ein Datenverlust unwahrscheinlich ist. Der Microsoft-Standardtreiber nutzt hingegen zusätzlich das ältere Verfahren Forced Unit Access (FUA) und bremst damit bei Schreibzugriffen die Performance der SSD aus. Anwender, die statt des Samsung-Treibers lieber die Microsoft-Variante zur Ansteuerung der NVMe-SSD nutzen möchten, können FUA über den Gerätemanager für das jeweilige Laufwerk ausschalten (Von Windows veranlasstes Leeren des Geräteschreibcaches deaktivieren). Dann liefern die SSDs auch mit dem Microsoft-Treiber ihre volle Leistung.

Over-Provisioning

Überprovisionierung ist ein übliches Verfahren zur Steigerung der Lebensdauer und der Leistungsfähigkeit eines SSD-Speichers. Ein bestimmter Anteil des vorhandenen Speicherplatzes wird für den Controller und das Dateisystem reserviert.

Bevor eine Speicherzelle wieder beschrieben werden kann, muss sie gelöscht werden.

Hierfür lagert der Controller die vorhandenen Daten auf einen ungenutzten Datenbereich aus und löscht dort, die nicht mehr benötigten Daten, genauer gesagt behält die noch gültigen Daten. Je mehr Daten auf einer SSD gespeichert sind, desto kleiner sind die freien Bereiche zum Verschieben der Daten und desto mehr Zeit wird für den Vorgang benötigt. Die Performance der SSD sinkt.

Überprovisionierung hält einen konstanten Bereich der SSD für den Controller und die temporären Verschiebevorgänge frei. Sollten Blöcke des regulär genutzten Speichers aufgrund von Alterungsprozessen oder anderen Problemen nicht mehr nutzbar sein, können Blöcke aus dem reservierten Bereich die Aufgabe der defekten Speicherblöcke übernehmen. Der überdimensionierte Speicher wird zwar kleiner, aber die Lebensdauer der SSD steigt.

Bei Windows einfach nicht die gesamte Festplatte formatieren, lasst 10 % frei/uneingeordnet und der Rest macht der Controller.

Aber Vorsicht: SSD muss sich im werkseitig originalen Standardzustand befinden! Denn sobald etwas auf SSD geschrieben ist, bleibt es dort, und der Controller weiß nicht, dass er diese Zellen als "leeren" Raum für zusätzliches OP und Wear-Leveling behandeln sollte. Wenn Du es vergessen hast, es einzurichten, bevor zum ersten Mal darauf geschrieben wird und OP neu zu definieren, setzen Sie SSD zuerst mit einer Software mit dem Befehl "ATA secure erase" (gpartet oder Samsung Magician 7 usw.) in den werkseitigen Standardzustand zurück.

Overprovisioning für Intel SSDs

Die Oper-Provisioning-Einstellung einer SSD kann von einem Benutzer geändert werden. Es muss auf einer SSD durchgeführt werden, die sich in einem vollständig sauberen Zustand befindet. Dies kann eine SSD sein, die frisch aus der Box ist, die noch nie verwendet wurde, oder durch sicheres Löschen der SSD.

Sie können die Intel Solid-State Drive Toolbox verwenden, um einen sicheren Löschvorgang durchzuführen, wenn sich die® SSD nicht in einem sauberen Zustand befand. Um eine Intel SSD sicher zu löschen, laden Sie Intel® Solid-State Drive Toolbox 2.0 von http://www.intel.com/go/ssdtoolbox herunter und befolgen Sie die Schritte zum Durchführen eines sicheren Löschens auf der SSD. (Industrie-Tools sind auch verfügbar, um eine SSD mithilfe von ATA-Befehlen sicher zu löschen). Sobald sich die SSD in einem sauberen Zustand befindet, reduzieren Sie die nutzbare Kapazität (wodurch der Ersatzbereich vergrößert wird) mit einer von zwei Methoden:

Geben Sie den Befehl SET MAX ADDRESS (Teil der ATA-Spezifikation) ein, um die maximale Adresse festzulegen, die das Betriebssystem sehen kann. HDPARM* und HDAT2* sind Branchentools von Drittanbietern, mit denen dieser Befehl ausgegeben werden kann.

Definieren Sie eine Partition, die kleiner als die maximal verfügbare Kapazität der SSD ist. Diese Option finden Sie in den Konfigurationstools für das Betriebssystemlaufwerk.

Sowohl SET MAX ADDRESS als auch die Partitionierung reduzieren den vom Benutzer adressierbaren Speicherplatz und ermöglichen es der SSD, den verbleibenden Speicherplatz als Teil des „bereit zum Schreiben“ -Ressourcenpools zu verwenden.

In den folgenden Schritten wird beschrieben, wie Sie das HDAT2-Programm für die Überbereitstellung auf einem Windows-basierten PC konfigurieren.

1. Bereiten Sie einen bootfähigen DOS-USB-Speicherstick vor, indem Sie ein freeDOS-Image mit Rufus erstellen.

A. Laden Sie die neueste Version von Rufus von diesem Link herunter. https://rufus.akeo.ie/

B. Führen Sie das Programm aus. Es wird nicht installiert, da es sich um ein eigenständiges Programm handelt.

2. Laden Sie das HDAT2-Programm von dieser Website herunter und kopieren Sie HDAT2.exe auf den USB-Stick.

3. Stellen Sie Ihr BIOS ein und stellen Sie sicher, dass der USB das erste bootfähige Gerät ist.

4. Schließen Sie die SSD an einen SATA-Festplattensteckplatz an und starten Sie den Computer neu.

5. Der Computer sollte über USB gestartet werden, und eine Befehlszeilenschnittstelle wird auf dem Bildschirm angezeigt.

6. Geben Sie „HDAT2“ ein und drücken Sie dann die Eingabetaste. Der Name und die Kapazität des SSD-Modells werden auf dem Bildschirm angezeigt.

7. Drücken Sie die Eingabetaste und bewegen Sie den Cursor zum Menü „max (HPA) einstellen“. Drücken Sie die 9 Enhancing the Write Performance of Intel SSDs through Over-Provisioning Enter Taste und das Menü „Set Max address“ erscheint.

8. Drücken Sie die Eingabetaste. Die drei unten beschriebenen Bereiche werden angezeigt:

Nativer Bereich = die maximale Kapazität des Laufwerks im Standard-Werkszustand

Benutzerbereich = die maximale Kapazität nach Aktivierung des Overprovisionings (auch manuell festgelegter max LBA)

Versteckter Bereich = Heimatbereich – Benutzerbereich. Die Größe des ausgeblendeten Bereichs sollte auf dem Bildschirm angezeigt werden.

9. Multiplizieren Sie die Sektornummer mit der Überbereitstellungsebene (Prozentsatz). Wenn unter anderem die Überbereitstellungsstufe auf einem 160-GB-SSD-Gerät 20 % beträgt, beträgt der Benutzerbereich nach der Überbereitstellung 312602976 x (1–0,2) = 250082380.

10. Drücken Sie Einfügen und geben Sie den neuen Wert ein. Drücken Sie „S“ und wählen Sie dann „Y (Ja)“. Drücken Sie dann eine beliebige Taste, um den Vorgang abzuschließen.

11. Starten Sie den Computer neu (verwenden Sie diesmal den lokalen Betriebssystemdatenträger zum Booten).

12. Überprüfen Sie die neue Kapazität über den Festplatten-Manager im Windows-Betriebssystem.

Hinweis: Wenn Sie eine andere Laufwerkskonfiguration verwenden möchten, können Sie dies tun, indem Sie in Schritt 9 andere Werte eingeben (z. B. ein 96G-Laufwerk anstelle eines 160G-Laufwerks).

RAID früher und heute?

RAID bei HDD immer noch sinnvoll und wie schaut es bei SSD und NVMe aus ?

1. Was ist ein SSD-Raid

Die Abkürzung RAID steht für „Redundant Array of Independent Disks“ (zu Deutsch „Redundante Anordnung unabhängiger Festplatten“) und beschreibt ein System, bei dem separate Festplatten zu einer logischen Einheit zusammengeschlossen werden. Wie oben schon beschrieben, dürft ihr das Overprovisioning auch bei einem RAID nicht vergessen.

Verschiedene Konfigurationen von RAID, die als Level bezeichnet werden und jeweils spezifische Vorteile hinsichtlich Datenverfügbarkeit, Speicherkapazität, Geschwindigkeit und Kosten haben. Um die Steuerung der Daten-Verteilung kümmert sich dabei ein sogenannter RAID-Controller, der einen eigenen Prozessor und RAM besitzt und die Berechnungen sämtlicher RAID-Operationen übernimmt (Hardware RAID).

Alternativ lässt sich ein RAID aber auch mittels Software umsetzen, wir sparen die Kosten für den RAID-Controller und es kommen gewöhnliche Festplatten-Controller (SATA oder SAS) zum Einsatz und die Berechnungen für die RAID-Operationen gehen zulasten der CPU des Servers.

Welcher RAID-Level ist die Frage, gerne wird einer der gebräuchlichsten, die Level 0 bis 5 sind, unter anderem in Hinblick auf die zur Verfügung gestellte Speicherkapazität und der Ausfallsicherheit genommen.

RAID 0 (Striping) sorgt für mehr Tempo, da die Daten parallel auf mehrere Laufwerke geschrieben und auf diese Weise höhere Transferraten erreicht werden. RAID 0 stellt 3 TB zur Verfügung, die Ausfallwahrscheinlichkeit beträgt 2,9701 %RAID 1 (Mirroring) erhöht durch eine Spiegelung der Festplatten-Inhalte die Datensicherheit und gewährleistet deren Verfügbarkeit, falls ein einzelnes Laufwerk ausfallen sollte. RAID 1 stellt 1 TB zur Verfügung, die Ausfallwahrscheinlichkeit beträgt 0,0001 %RAID 5 (Performance) stellt eine schlaue Kombination aus Schnelligkeit und Datensicherheit dar. Der Controller schreibt gleichzeitig auf alle Platten des Verbundes und legt parallel eine Sicherung der Informationen über alle anderen Laufwerke an. Auf diese Weise lassen sich die Daten beim Ausfall einer Festplatte mithilfe der anderen Laufwerke wiederherstellen. RAID 5 stellt 2 TB zur Verfügung, die Ausfallwahrscheinlichkeit beträgt 0,0298 %. (Quelle: Wikipedia). Ich selbst würde immer einem RAID 10 mit mindestens vier, lieber aber acht Festplatten den Vorzug geben!

SSD RAID

In der Regel werden RAID-Systeme mit herkömmlichen Magnetfestplatten realisiert, grundsätzlich funktioniert das Prinzip aber auch mit schnellen SSDs. Allerdings müssen Sie dann einige zusätzliche Parameter und Kriterien beachten. Denn im Gegensatz zu herkömmlichen HDDs verfügen SSDs weder über mechanisches Schreib- und Leseköpfe, noch Magnetplatten, sondern basieren auf elektrischen Zellen. Die Technik ist in etwa vergleichbar mit der Funktionsweise eines USB-Sticks oder anderen Flash-Speichern.

SSDs verfügen im Gegensatz zu herkömmlichen HDDs verfügen SSDs weder über mechanisches Schreib- und Leseköpfe noch Magnetplatten, sondern basieren auf elektrischen Zellen.

Dadurch ergeben sich zwar wesentlich geringere Zugriffszeiten, im RAID-Verbund verliert die SSD aber an Tempo. Hinzu kommt noch der Umstand, dass SSDs eine spezielle Organisation mithilfe des sogenannten „TRIM-Befehls“ erfordern. Dieser steht allerdings innerhalb des RAID nicht mehr zur Verfügung.

Die Daten in einem RAID können nur ausgelesen werden, indem die Zugriffe (lesend wie schreibend) auf allen Laufwerken gleichzeitig erfolgen. Genau darin liegt bei einem SSD-Verbund jedoch die Krux: Denn die Wartezeit beim Zugriff richtet sich immer nach dem langsamsten Laufwerk. Das bedeutet, dass ein wesentlicher Vorteil der SSD, nämlich die schnellen Zugriffszeiten, nicht in vollem Maße ausgereizt werden kann.

Wie oben bereits erwähnt, ist auch die Nutzung des TRIM-Befehls durch den Zusammenschluss im RAID nicht mehr möglich. Somit erhält das Laufwerk vom Betriebssystem auch keine Informationen mehr darüber, welche Blöcke im Flash-Speicher ungenutzt sind und somit von der SSD nicht mehr bereitgehalten werden müssen. Im Zuge dessen verlangsamt sich nicht nur die Arbeitsgeschwindigkeit, sondern auch die Lebensdauer der eigentlich sehr flotten und robusten SSD.

Im Einzelfall, macht einer SSD so schnell keiner was vor: Schnelle Zugriffszeiten, unempfindlich gegen Stöße und auch bei extremen Bedingungen stets zu Diensten, schließt die NVMe nicht aus. Anders sieht es allerdings aus, wenn Sie die flotten Laufwerke zu einem RAID verbinden. Denn damit sinkt nicht nur das Arbeitstempo der SSD, die fehlende TRIM-Funktionalität wirkt sich langfristig auch auf deren Lebenserwartung aus. Deswegen wird von SSDs im RAID für gewöhnlich auch abgeraten. Wenn ihr es doch mal selber ausprobieren möchtet, dann verzichtet nicht auf das Overprovisioning!

Wenn der RAID-Controller defekt ist, kommt ihr übrigens auch nicht mehr an eure Daten heran. Eine Alternative wäre unter Windows die Software StableBit Pool Drive, eine frühere Version wie sie damals unter Windows Home Server v1 implementiert war. Die heutigen Ableger sind aber weitaus umfangreicher und besser als die frühe Implementierung, sie können sogar ein IO Drive zum Cachen der Daten selektiv ansteuern,

StableBit PoolDrive anstatt Raid oder NAS

Was macht das genau?

Es legt einen versteckten Ordner in jede Festplatte, die zum Pool gehört, an und kopiert in diesem die Daten. Sollte nun mal eine Festplatte ausfallen, sind diese immer noch auf einer anderen Festplatte vorhanden. Selbst wenn ihr eure OS Festplatte verlieren sollte, sind diese Daten noch vorhanden und könnt diese in ein anderes System einhängen und in den Ordneroptionen versteckte Ordner anzeigen, so wieder Zugriff auf eure Daten erhalten.

Auch das kopieren und lesen von Daten geht recht zügig, da Daten verteilt auf mehrere Laufwerke liegen. Ähnlich wie beim ZFS System unter Linux.

Ihr seid nicht abhängig vom RAID Controller.

Könnt Poolplatten auch einzeln auslesen.

Slc mlc tlc

Habe mir eine HP 160 GB SLC PCI-e IO Accelerator Low Profile Bracket gekauft.

Baujahr war damals so zwischen 2008 und 2012 und im Grunde der Vorgänger von NVMe. Diese wurde aber nur über einen Treiber angesprochen und war nicht wie heute direkt an eine CPU wie AMD Epyc angebunden.

Der Typ der Speicherbausteine steht ja in der Modellbezeichnung,

Single Layer Cell sind 1 Bit Speicher, die hochwertig im Gegensatz zu TLC und MLC sind, aber gerade bei Schreibintensiven Anwendungen weitaus zuverlässiger sind.

Multi Layer Cell hier gut bei Wikipedia erklärt.

Tribble Layer Cell bei Wikipedia nachzulesen.

HPE IO Accelator Geschwindigkeit

Die Werte schauen schon mal sehr gut aus, liegen über die einer SATA SSD.

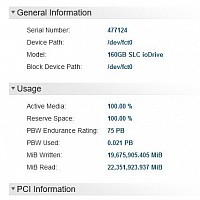

SMART Werte? 75 PB Schreibleistung!

Crystal Disk Info konnte keine Werte erfassen 🤔 Geschrieben wurden bis jetzt 0.021 PB also 21 TB eigentlich ist das ja noch nicht einmal warm gelaufen😮💨 sozusagen eine Tageszulassung 😱 und wegen des SLC Speicher noch lange keine Alterung in Sicht.

Storage Space mit SSD-Cache

Nun gibt es wieder einen neuen Beitrag von mir :-). Diesmal zum Thema Storage Spaces. Storage Spaces sind die inoffiziellen Nachfolger des Windows Home-Server Balancings und seit Windows 8 in Windows integriert. Mit Windows 10 gibt es nun auch die Möglichkeit ein Storage Space mit SSD-Cache zu erstellen.

Storage Spaces bieten dabei die Möglichkeit mehrer physikalische Festplatten zu einem logischen Laufwerk zusammenzufassen. Dabei werden die folgenden Modi unterstützt:

Spiegelung 2-Wege-Spiegelung 3-Wege-Spiegelung- Parität Einfach (keine Resilizenz)

Windows 10 hat nun einige neue Funktionen erhalten, die unter Windows 8.1 lange vermisst wurden.

Ausgleich über mehrere Festplatten, auch Laufwerksoptimierung genannt Entfernen von Festplatten aus dem Verbund Storage Tiering, also die Möglichkeit schnellen SSD Speicher als Cache für Festplatten zu nutzen

Beim Storage Tiering werden zwei verschiedenen Bereich gebildet. Häufig genutzte Daten (Hot-Data) werden in den SSD-Bereich verschoben und von dort ausgeliefert. Weniger häufig genutzte Daten (Cold-Data) werden von dem HDD-Bereich ausgeliefert. Per Wartungsaufgabe wird in regelmäßigen Abständen die Nutzung des SSD-Bereichs optimiert. Der write-back-Cache wird bei einfachen und gespiegelten Speicherplätzen genutzt um zufällige Schreiboperationen auf die SSD umzuleiten und dann später gebündelt an die HDD weiterzugeben. Der write-back-Cache wird erst genutzt, sobald der SSD-Cache vollständig gefüllt ist.

Unter Windows 10 lässt sich das Tiering der Storag Spaces nur per PowerShell nutzen. Weiterhin ist es nicht möglich einen bestehende Speicherplatz, mit enthaltenen Daten um ein SSD-Cache zu erweitern.

Voraussetzungen

Folgende Tabelle zeigt, wie viele Festplatten und SSDs mindestens nötig sind um den entsprechenden Modus nutzen zu können.

Einfach 2-Wege-Spiegelung 3-Wege-Speigelung Parität

SSD 1 2 3 3

HDD 1 2 3 3

Erstellung

1.) Festplatte vorbereiten

Alle Daten der später verwendeten Laufwerke sichern Partitionen löschen unter Systemteuerung -> System und Sicherheit -> Festplattenpartitionen erstellen und formatieren

2.) Festplatten zu einem neuen Pool zusammenschließen

Entweder über die Oberfläche unter Systemsteuerung -> System und Sicherheit -> Speicherplätze Wichtig ist, dass bei Nutzung der GUI keine neue Virtuelle Festplatte (auf deutsch auch Speicherplatz) erstellt wird. Oder folgendes in die PowerShell mit Admin-Rechten eingeben

$pd = (Get-PhysicalDisk -CanPool $True | Where MediaType -NE UnSpecified) New-StoragePool -PhysicalDisks $pd -StorageSubSystemFriendlyName "Storage Spaces*" -FriendlyName "Speicherpool"

3.) Virtuelle Festplatte mit SSD-Cache erstellen

Folgendes in der PowerShell mit Admin-Rechten eingeben

$ssd_Tier = New-StorageTier -StoragePoolFriendlyName "Speicherpool" -FriendlyName SSD_Tier -MediaType SSD $hdd_Tier = New-StorageTier -StoragePoolFriendlyName "Speicherpool" -FriendlyName HDD_Tier -MediaType HDD New-VirtualDisk -StoragePoolFriendlyName "Speicherpool" -FriendlyName "Speicherplatz" -StorageTiers @($ssd_tier, $hdd_tier) -StorageTierSizes @(128GB, 3750GB) -ResiliencySettingName Simple -WriteCacheSize 8GB

In diesem Beispiel wird eine neue virtuelle Festplatte mit der Gesamtgröße von 3878GB (3750 + 128) erstellt. Hier ist keine Spiegelung oder Parität eingestellt. Der SSD-Cache ist in diesem Beispiel 128GB groß, der Festplattenanteil 3750GB. Dazu wird ein write-back-Cache in Größe von 8GB genutzt.

4.) Bericht aktivieren

Mit folgendem Befehl in der PowerShell wird nach jeder Optimierung der Bericht unter C:\Windows\StorageTiersOutput.txt aktualisiert. Darin ist z.B zu sehen ob die Größe des SSD-Caches ausreicht.

schtasks /change /tn "\Microsoft\Windows\Storage Tiers Management\Storage Tiers Optimization" /tr "cmd /c %windir%\System32\defrag.exe /c /h /g /# > %windir%\StorageTiersOutput.txt"~ ~

schtasks /change /tn "\Microsoft\Windows\Storage Tiers Management\Storage Tiers Optimization" /tr "cmd /c C:\Windows\System32\defrag.exe /c /g /# > C:\Windows\StorageTiersOutput.txt"

5.) Optimierung manuell starten

Die Optimierung läuft nach den Standard-Einstellungen alle 4 Stunden. Manuell lässt sich die Optimierung durch folgenden PowerShell-Befehl starten:

Get-ScheduledTask -TaskName "Storage Tiers Optimization" | Start-ScheduledTask

TIER Stufen

### Tier 0 (Very High-Performance Storage)

- **Beispiele**: NVMe-SSDs, RAM-Disk

- **Merkmale**: Sehr hohe Leistung und geringe Latenz, aber hohe Kosten pro Gigabyte.

- **Verwendung**: Kritische Anwendungen, die extrem schnelle Zugriffszeiten erfordern, wie transaktionsintensive Datenbanken, In-Memory-Analytics.

### Tier 1 (High-Performance Storage)

- **Beispiele**: SAS-SSDs, Performance-optimierte SAS-HDDs

- **Merkmale**: Hohe Leistung mit etwas geringerer Geschwindigkeit im Vergleich zu Tier 0, aber immer noch teuer.

- **Verwendung**: Primärspeicher für Unternehmensanwendungen, Datenbanken und virtuelle Maschinen.

### Tier 2 (Mainstream Storage)

- **Beispiele**: SATA-SSDs, 10K bis 15K RPM SAS-HDDs

- **Merkmale**: Balance zwischen Kosten und Leistung. Weniger kostspielig als Tier 1.

- **Verwendung**: Sekundärspeicher, allgemeine Anwendungen und Dateien, die häufig verwendet werden.

### Tier 3 (Nearline Storage)

- **Beispiele**: 7200 RPM SATA-HDDs, Nearline-SAS

- **Merkmale**: Günstigere Kosten pro Gigabyte, aber geringere Leistung.

- **Verwendung**: Dateispeicher, Backup-Dateien, Archiving von Daten, auf die nicht häufig zugegriffen wird, aber dennoch schnell abgerufen werden müssen, wenn sie gebraucht werden.

### Tier 4 (Archival Storage)

- **Beispiele**: Tape-Libraries, Optical Disks

- **Merkmale**: Sehr niedrige Kosten pro Gigabyte, aber hohe Latenz. Hauptsächlich für die Langzeitarchivierung vorgesehen.

- **Verwendung**: Langzeitarchivierung von Daten, auf die selten zugegriffen wird.